En 2017, First Draft a lancé un projet de journalisme collaboratif autour de la campagne présidentielle française, rassemblant 37 rédactions, partenaires technologiques et universitaires originaires de France, de Grande-Bretagne et de Belgique. Le référendum du Brexit et les élections présidentielles américaines de 2016 avaient fait naître un sentiment d’urgence au sein des médias, la désinformation se répandant dans les réseaux sociaux. Il existait un besoin conscient d’aborder les questions de confiance et de transparence entre les médias et leur public.

Plus de 100 journalistes répartis dans 33 rédactions ont ensemble surveillé le Web social. Ils ont collaboré sur 63 contenus « problématiques ». Conformément aux sept types de mésinformation et de désinformation de Claire Wardle, les journalistes ont évité de se limiter aux termes « vrai » et « faux », trop simplistes et souvent trompeurs, afin de mieux comprendre les outils et techniques utilisés par les créateurs de hoax et les propagandistes et de les signaler plus efficacement au public.

En novembre 2019, First Draft a mis en place une opération de veille pour enquêter à nouveau sur l’espace d’information en ligne français. Cette nouvelle phase, qui mène aux élections municipales de mars 2020, montre à quel point cette ère de désordre informationnel évolue rapidement et se complexifie. La nécessité de mieux se préparer et d’unir nos forces pour y faire face est plus évidente que jamais.

Certaines caractéristiques notoires de cet environnement informationnel ont persisté depuis 2017, inévitablement. La désinformation politique en ligne vise souvent à renforcer un petit nombre de narratifs récurrents, dont un grand nombre tournent autour du sentiment anti-immigration et de la perception de troubles sociaux.

De vieilles photos et vidéos sont encore souvent utilisées comme « preuves » pour étayer ces narratifs et provoquer de fortes réactions émotionnelles. Parmi les messages récents, on trouve une ancienne photo de confrontation policière (capture d’écran ci-dessous) et une vidéo d’Iran présentée comme représentant la police anti-émeute française. Ces exemples rappellent les désinformations découvertes en 2017, lorsqu’une crise de réfugiés en Turquie, ainsi que des images et des cartes, més-attribuées, accusant à tort les immigrants de crimes, ont été utilisées pour promouvoir des narratifs de troubles sociaux, de répression gouvernementale et d’immigration massive incontrôlée.

Photo prise en 2010, publiée à nouveau en septembre 2019. Capture d’écran par l’auteur.

Parmi les sources qui ont avancé des contenus problématiques en 2017, beaucoup sont restées actives et ces sites Web et comptes de réseaux sociaux bien suivis continuent d’influencer les communautés en ligne qui leur sont réceptives. Ils ont réussi à conserver leur rôle dans la sphère dite « patriotique » ou même « fachosphère », malgré des sources d’information reconnues qui détaillent l’étendue de leur tromperie.

Cependant, en moins de deux ans, ces tactiques ont évolué. Voici cinq exemples de développements significatifs que nous avons identifiés au cours de notre dernier projet de veille.

Plus de faux contexte, peu de fabrication

Les éléments fabriqués ou mal manipulés constituaient une partie, limitée mais non négligeable, des affirmations qui ont été vérifiées par CrossCheck en 2017. Des rumeurs non fondées visant à saper la crédibilité des candidats, des résultats de vote fabriqués à partir de narratifs portés par des comptes imposteurs et des photos mal manipulées utilisées pour générer des gros titres aptes à générer de l’attraction sont autant d’exemples de contenus fabriqués qui ont parfois fait surface à l’approche de l’élection présidentielle.

Peu de cas d’éléments fabriqués ont été relevés au cours de notre dernière période de veille, fin 2019. La plupart n’ont pas réussi à susciter beaucoup d’attention. La majorité des éléments de désinformation efficaces reposaient sur des conjectures subtiles et de fausses déclarations. Parmi les exemples récents, on peut citer des citations abrégées destinées à amplifier les réactions polarisantes de personnalités publiques controversées et des sondages d’opinion anciens qui nuisent aux hommes et femmes politiques.

Le faux contexte est maintenant utilisé de manière plus stratégique pour générer plus d’intérêt en ligne. Au cours des derniers mois de 2019, deux exemples remarquables ont émergé lorsque des informations obsolètes et incomplètes ont circulé à des moments précis, choisis afin de tirer profit des tensions existantes et de maximiser la tromperie.

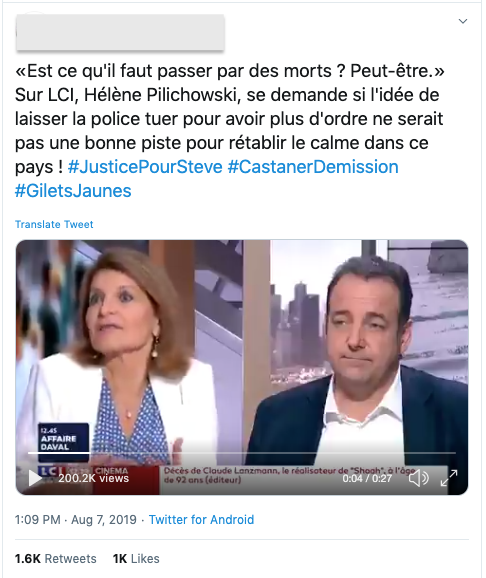

Dans un journal télévisé de 2018, une journaliste de la chaîne nationale LCI avait suggéré qu’il y avait peut-être « besoin d’un mort », pour rétablir les relations entre les manifestants et la police. Cette citation très controversée a été publiée à nouveau sur Twitter un an plus tard, mais, fait crucial, quelques jours seulement après la découverte du corps d’un jeune homme dont la disparition avait été liée à une violente intervention policière lors d’un spectacle de musique. Le message contenait des hashtags liés à l’affaire et ne comportait aucune indication de la date initiale de l’entretien, laissant croire à de nombreux utilisateurs en ligne que les commentaires étaient liés à l’affaire. Plusieurs sites Web d’information peu fiables, ainsi que des médias internationaux ont alors publié des articles qui utilisaient la citation comme titre sans mention de la date d’origine. Ils ont également été largement diffusés sur les réseaux sociaux. Le moment choisi pour la publication de ces messages a polarisé encore davantage les débats et controverses sur les violences policières et la partialité des médias en France.

Cette vidéo de 2018 est postée sur Twitter avec les hashtags « justice pour Steve », « Castaner démissionne maintenant », « Gilets jaunes ».

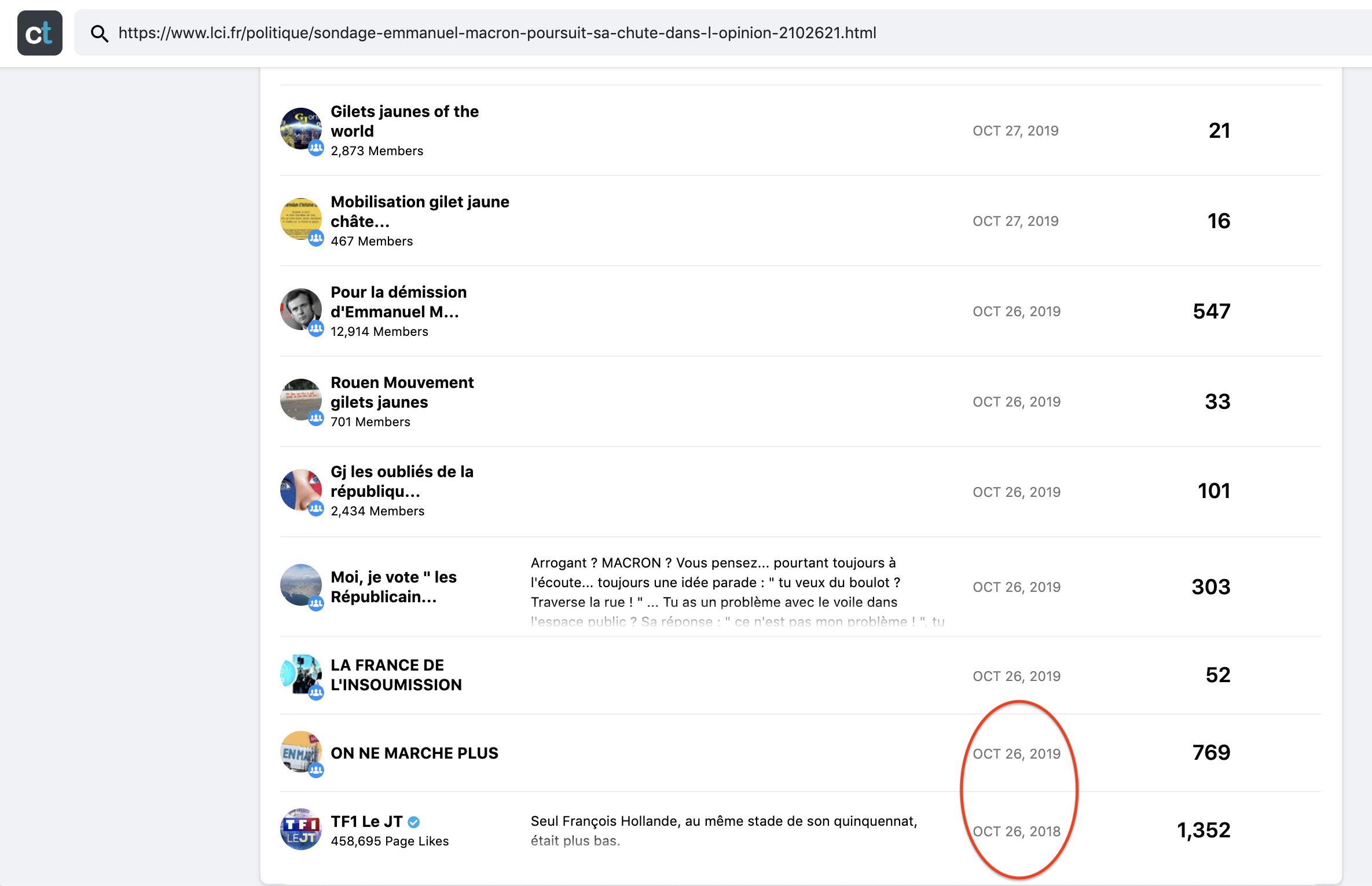

De même, un sondage d’opinion publié le 26 octobre 2018 a révélé que la cote de popularité de M. Macron était tombée à son plus bas niveau depuis son investiture. Ce jour-là, LCI a publié le sondage dans un article intitulé « Sondage d’opinion : jugé « arrogant », Emmanuel Macron poursuit sa chute dans l’opinion ». Cet article, dont la vignette ne comporte aucune indication sur sa date de publication lorsqu’il est partagé en tant que message sur un réseau social, a ensuite été re-publié sur six groupes Facebook exactement un an plus tard, le 26 octobre 2019.

La fonction LinkSearch de CrowdTangle est utilisée pour suivre les liens URL partagés sur les plateformes de réseaux sociaux. Capture d’écran par l’auteur.

Les messages contenant des liens anciens vers le sondage ont été publiés sur des dizaines de groupes Facebook totalisant plus de 350 000 membres et ont donné lieu à plus de 8 000 interactions au cours du mois suivant.

« Recyclage » des contenus et partage coordonné des liens

Plusieurs articles trompeurs ou inexacts qui ont été rapportés sur CrossCheck en 2017 avaient été diffusés par un certain nombre de sites d’information peu fiables. Des résultats de sondages més-attribués, des allégations sans fondement de censure politique et des rapports mensongers impliquant l’érosion de la culture française ont tous été amplifiés par un certain nombre de sources en ligne tout aussi peu fiables. Les liens entre ces sources en ligne sont souvent explicites : les « liens recommandés » et les « logos des partenaires » apparaissent en bas de la plupart de ces sites Web. Les éléments identifiés par notre dernier projet de veille en 2019 suggère que ces réseaux recyclent les contenus plus fréquemment et sont devenus moins dépendants de leurs propres contenus originaux.

Dans les trois cas mentionnés ci-dessus, chaque site Web avait produit son propre contenu original autour de l’histoire. Dans le cadre du projet de veille de 2019, la plupart des mésinformations sous forme d’articles en ligne avaient été amplifiées par de nombreux sites Web, souvent simplement copiées ou abrégées d’un site Web à l’autre. Une citation abrégée et hors contexte d’un article coécrit par Greta Thunberg, par exemple, a fait l’objet de trois versions différentes de l’article, des copies identiques de chacune d’entre elles étant utilisées par au moins trois sites Web distincts.

Plusieurs sites Web publiant des histoires identiques en utilisant comme titre une citation abrégée.

Un tel « recyclage » des contenus peut renforcer la désinformation en augmentant sa portée, tablant sur le fait que la multiplicité des écrits autour d’une même question peut contribuer à créer une illusion de valeur médiatique et, par conséquent, de crédibilité.

En outre, certains réseaux de désinformation diffusent désormais leur contenu de manière plus coordonnée sur les réseaux sociaux principaux. Notre veille de 2019 a identifié des liens d’articles provenant de plusieurs nouveaux sites de « ré-information », diffusés sur un certain nombre de pages et de groupes Facebook en quelques minutes. Des articles provenant de ces sources, y compris des citations manipulées et démystifiées (capture d’écran ci-dessous), ou des contenus satiriques reconvertis ont été publiés sur une demi-douzaine de pages et de groupes en moins de quatre minutes. Une enquête conjointe du journal Le Monde et du EU Disinfo Lab a révélé que ces sites faisaient partie d’un réseau étranger de faux comptes.

Une fausse déclaration suggérant que la secrétaire d’État Mme Schiappa voulait interdire la diffusion des cérémonies religieuses à la télévision. Capture d’écran par l’auteur.

Ces tactiques ont également été observées récemment dans d’autres sphères en ligne. Des chercheurs de l’université d’Urbino ont constaté que de nombreux réseaux de Groupes, Pages et profils publics sur Facebook avaient diffusé des liens de manière coordonnée pendant la campagne électorale de 2018 et les élections européennes de 2019 en Italie.

De telles tactiques pourraient se multiplier lors des prochains cycles électoraux, car l’étude a montré qu’en moyenne, les liens partagés de manière coordonnée génèrent plus d’interactions que les autres.

Militarisation du contenu satirique

En 2017, cinq articles satiriques avaient été vérifiées par CrossCheck après qu’un certain nombre d’utilisateurs aient pris leur contenu au sérieux. Le caractère satirique des sources était souvent facile à repérer, soit par leur nom, comme le jeu de mots Le Gorafi en lien avec Le Figaro, soit par le type de contenu hébergé sur leur site Web. Dans l’un des cas, un site de canulars a été utilisé pour fabriquer une proposition politique controversée « mise en avant » par le candidat de l’époque, Emmanuel Macron.

La satire continue de jouer un rôle majeur dans les conversations politiques en ligne: ce rôle est essentiel tant que tous comprennent l’aspect humoristique du propos. Cependant, il semble que le contenu satirique en ligne fasse aujourd’hui l’objet d’une utilisation plus concertée et plus ciblée que dans les exemples qui avaient été observés dans le projet CrossCheck en 2017.

Un site Web satirique créé en avril 2019 qui imite le nom et le logo de France TV a vu deux de ses articles se propager, l’un d’eux générant presqu’un demi-million d’interactions sur Facebook. L’apparence trompeuse et l’humour subtil des articles (une « citation » fabriquée, mais que certains pourraient juger crédible du président Macron) ont été utilisés pour polariser davantage le débat sur la présidence de Macron. Les utilisateurs ont diffusé ces liens sur de nombreux groupes Facebook avec des légendes à caractère émotionnel qui suggéraient que la citation était authentique. Certains messages contenant des légendes identiques ont été partagés en rafales. Certains ont atteint jusqu’à quatre groupes en 16 secondes, selon les données de CrowdTangle. En outre, l’un des sites de désinformation faisant partie d’un réseau de sources d’information non authentiques a copié l’article satirique et l’a publié en même temps que d’autres articles non satiriques. Ce lien a ensuite été diffusé simultanément sur les Pages publiques et les Groupes Facebook (5 en moins de 4 minutes) avant de circuler sur de nombreux autres sites plus tard dans la journée.

Au cours des derniers mois, la satire a également été utilisée pour cibler et discréditer certains hommes et femmes politiques. Un compte Twitter de parodie plaisantait sur le fait que la porte-parole du gouvernement, Sibeth N’Diaye, soutenait un politicien de haut niveau, qui avait récemment été reconnu coupable d’activités frauduleuses en postant une citation fabriquée de toutes pièces. Le tweet a été capturé et recadré pour masquer la nature satirique de la source. Ce visuel manipulé a ensuite été largement diffusé sur Facebook par le biais de messages comportant des légendes incendiaires. De même, une autre citation forgée de toutes pièces à partir d’un site Web satirique « desourcesure » se moquant de Mme N’Diaye a été utilisée pour créer un mème qui a ensuite été largement diffusé sur les réseaux sociaux. Le mème comportait également la phrase « qui a voté pour cela ? », dans une tentative évidente de provoquer une réaction émotionnelle. Dans les deux cas, de nombreux utilisateurs ont réagi avec des émoticônes « en colère » et de nombreux médias ont publié des vérifications de faits connexes.

Photo contenant une citation satirique forgée de toutes pièces, mais recadrée pour cacher la nature satirique de la source. Elle est accompagnée de la légende « S’il vous plaît, faites-la taire !! ». Capture d’écran par l’auteur.

L’utilisation de citations forgées de toutes pièces sur des images pour cibler les personnes de couleur dans les fonctions publiques reflète l’évolution de la situation à l’approche des élections de 2019 au Royaume-Uni, où des tactiques identiques ont été employées pour nuire aux candidats.

Ces mèmes et images superposés au texte sont devenus un outil de désinformation de plus en plus courant et présentent des défis singuliers pour le public en ligne et les journalistes.

Mèmes et textes sur images

À l’exception de ce lien d’article qui présentait une image sous forme de vignette, aucun texte sur images trompeur ou inexact n’a été signalé par CrossCheck en 2017. En revanche, peu de jours passent pendant le projet de veille de 2019 sans que des mèmes ou des images trompeuses ne soient diffusés en ligne. Les images qui comprennent des citations forgées de toutes pièces, des statistiques exagérées et un langage incendiaire ont montré qu’il est possible de provoquer de fortes réactions émotionnelles et de renforcer encore les convictions des individus au cours de ces derniers mois. Ces types de messages, qui étaient également un élément-clé de la désinformation en ligne lors des élections générales britanniques de l’année dernière, sont notoirement rapides et faciles à réaliser, mais peuvent être difficiles à suivre et à signaler.

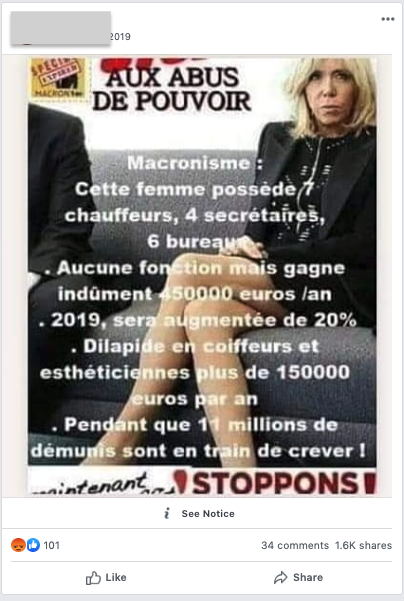

Des statistiques inexactes et trompeuses superposées à une photo de Brigitte Macron. Capture d’écran par l’auteur.

Les techniques et outils s’appuyant sur du texte pour surveiller le Web social sont pour la plupart inefficaces, car ces images sont souvent partagées sans légende. En outre, les outils qui permettent de suivre la circulation des contenus en ligne peinent à saisir des données précises pour les images manipulées ou éditées.

Une solution possible est l’extension de navigateur Project Naptha qui peut aider à extraire du texte d’une image. Le texte peut alors être utilisé pour essayer de déterminer si des informations identiques ont été partagées ailleurs, mais les résultats sont généralement rares.

Des recherches ont montré que les déclarations ont plus de chances d’être crues lorsqu’elles sont présentées à l’aide d’images. Comme celles-ci deviennent un outil de plus en plus courant pour diffuser la désinformation, il est plus que jamais essentiel de prendre en compte le mobile des sources quand elles utilisent l’imagerie pour promouvoir une opinion politique.

Plateformes alternatives

Les plateformes de réseaux sociaux « grand public », notamment Facebook et Twitter, sont toujours le lieu de la majorité des conversations politiques en ligne en France. Ces espaces restent donc les principaux champs de bataille pour les agents de la désinformation. Depuis 2017, ces plateformes jouent un rôle plus actif pour répondre à la diffusion de la désinformation en ligne. Des mesures telles que des politiques plus strictes en matière de modération des contenus et des comptes ainsi que des partenariats pour la vérification des faits par des tiers ont rendu ces plateformes plus hostiles aux agents de désinformation. Les rapports sur les retraits à grande échelle de faux comptes sont désormais presque hebdomadaires.

Au cours des deux dernières années, de nombreux sites d’influence et de désinformation au sein des communautés en ligne françaises ont cherché à encourager la diffusion de leurs contenus par le biais de plateformes alternatives, en grande partie non censurées. Dans plusieurs cas, ils ont créé leurs propres comptes pour diffuser leur contenu sur ces chaînes. Certaines sources opèrent désormais exclusivement par le biais de ces canaux après avoir été totalement bannies des plateformes grand public.

Plus précisément, VKontakte (communément appelée « VK ») et l’application de messagerie directe « Telegram » sont de plus en plus utilisées par les sources et les communautés françaises en ligne qui se plaignent souvent de censure du contenu. VK s’est développée pour accueillir des dizaines de groupes francophones dont certains comptent plusieurs milliers de membres. Telegram compte un nombre similaire de « chaînes publiques françaises d’information », bien que leur nombre d’abonnés soit plus limité – souvent moins d’un millier. Les liens vers les comptes VK et Telegram et les boutons « partager » se trouvent maintenant souvent sur les sites français de désinformation les plus populaires, alors que ceux-ci se limitaient souvent à Facebook, Twitter et YouTube en 2017.

Bien que nous ayons trouvé peu de preuves que des sources de désinformation partagent du contenu exclusif sur ces plateformes, plusieurs cas de désinformation qui ont fait surface sur Facebook circulaient également sur les groupes publics VK et les chaînes Telegram. En octobre 2019, le Rassemblement National a annoncé le lancement de sa propre chaîne Telegram, ce qui laisse entendre que les sources d’information en ligne peu fiables ne sont pas les seules à reconnaître le potentiel de ce moyen de communication.

Le candidat du Rassemblement National, Jordan Bardella invite les utilisateurs à suivre la nouvelle chaîne Telegram du parti. Capture d’écran par l’auteur.

Cette tendance n’est en aucun cas limitée à la France. Des plateformes telles que Gab, Bitchute et Brighteon continuent d’attirer des communautés qui partagent des contenus considérés comme promouvant des points de vue plus « extrêmes ». Les caractéristiques de ces plateformes posent de sérieux problèmes de sécurité et d’éthique pour les journalistes et les chercheurs. Cependant, à mesure que l’importance de ces plateformes augmente, le besoin de comprendre comment ces sphères numériques fonctionnent et comment elles peuvent affecter l’écosystème de l’information au sens large se fait sentir.

Avec le premier tour des élections municipales qui approche à grands pas et un climat permanent de contenu à forte charge émotionnelle et partisane sur les réseaux sociaux, la désinformation en ligne pourrait jouer un rôle encore plus important dans le débat politique. Alors que les tactiques utilisées pour diffuser des contenus trompeurs continuent d’évoluer, les électeurs doivent rester vigilants lorsqu’ils naviguent sur le Web social.

Marie Bohner a aussi contribué à cet article.

Restez en lien avec le travail de First Draft en vous inscrivant pour notre newsletter (en anglais) et en nous suivant sur Facebook et Twitter.