Nous vivons dans une ère de désordre informationnel. La promesse de l’ère numérique nous a poussés à croire que la vie en communautés hyper-connectées, où toutes les informations seraient accessibles en un clic ou un glissement de doigt, n’apporterait que des changements positifs. Mais cette vision idéalisée a été rapidement balayée par la prise de conscience que notre écosystème informationnel est désormais dangereusement pollué et qu’il nous divise plus qu’il ne nous unit.

Les sites Web imposteurs, conçus pour donner l’impression de sources d’informations professionnelles, diffusent du contenu particulièrement tendancieux et trompeur. De faux comptes publient des mèmes scandaleux sur Instagram et les fermes à clics manipulent les sections tendances des plateformes de réseaux sociaux et leurs systèmes de recommandation. Ailleurs, des agents étrangers se font passer pour des Américains pour coordonner des manifestations réelles entre différentes communautés tandis que les données personnelles sont collectées en masse pour cibler les électeurs avec des messages et des publicités sur-mesure. En plus de cela, les communautés conspirationnistes de 4chan et Reddit s’affairent à tromper les journalistes afin qu’ils couvrent des rumeurs ou des canulars.

Le terme « fake news » ne recouvre qu’une partie infime de ce phénomène. Une bonne part de ce contenu n’est pas forcément faux ; il est souvent authentique et sciemment utilisé hors contexte par des gens qui savent que les mensonges qui reposent sur une base de vérité sont plus susceptibles d’être crus et partagés. Et une grande partie de ce contenu ne peut pas être considéré comme de « l’information ». Il s’agit simplement de bonnes vieilles rumeurs, de mèmes, de vidéos manipulées et de « dark ads » (publicités sombres) hyper ciblées et de vieilles photos re-partagées comme étant nouvelles.

Il n’y a pas de terme qui décrive cette nouvelle réalité et c’est une des raisons pour lesquelles le terme de « fake news » n’est pas approprié. L’autre raison, plus poignante encore, est la façon dont cette technique a été utilisée par les politiciens du monde entier pour discréditer et attaquer le journalisme professionnel. Le terme est maintenant presque dénué de sens, le public l’associe de plus en plus à des médias établis tels que CNN et la BBC. Les mots sont importants et lorsque les journalistes utilisent le terme de « fake news » dans leurs reportages, ils légitiment une phrase inutile et de plus en plus dangereuse.

« Les agents de désinformation ont appris que le contenu authentique – reformulé de manière nouvelle et trompeuse – est moins susceptible d’être détecté par les systèmes d’IA.»

Chez First Draft, nous préconisons l’utilisation de termes plus appropriés pour chaque type de contenu ; qu’il s’agisse de propagande, de mensonges, de théories du complot, de rumeurs, de canulars, de contenu fortement tendancieux, de mensonges ou de manipulation médiatique. Nous préférons également utiliser les termes de désinformation, mésinformation ou malinformation. Collectivement, nous appelons cela le désordre informationnel.

DÉSINFORMATION, MÉSINFORMATION ET MALINFORMATION

La désinformation est un contenu intentionnellement faux et conçu pour nuire. Elle est motivée par trois facteurs distincts : gagner de l’argent, avoir une influence politique – étrangère ou nationale – ou pour nuire comme un but en soi.

Lorsque la désinformation est partagée, elle se transforme souvent en mésinformation. La mésinformation décrit également du faux contenu mais la personne qui partage ne se rend pas compte qu’il est faux ou trompeur. Souvent, un contenu de désinformation est récupéré par quelqu’un qui ne se rend pas compte qu’il est faux et le partage sur ses réseaux, avec l’intention d’aider.

Le partage de la mésinformation est motivé par des facteurs socio-psychologiques. En ligne, les personnes assoient leur identité. Ils aiment se sentir appartenir à leur « tribu », qu’il s’agisse de membres du même parti politique, de parents qui ne vaccinent pas leurs enfants, de militants préoccupés par le changement climatique ou de membres d’une certaine religion, race ou ethnie.

La troisième catégorie est la malinformation. Ce terme décrit des informations authentiques qui sont partagées avec l’intention de nuire. La malinformation désigne par exemple l’affaire dans laquelle des agents russes ont piraté des e-mails du Comité national démocrate et de la campagne d’Hillary Clinton et en ont divulgué certains détails au public pour nuire à leur réputation.

Il faut reconnaître que les techniques observées en 2016 ont évolué. Nous assistons de plus en plus à une manipulation du contexte : l’utilisation de contenu authentique – mais déformé

et reformulé. Tout ce qui contient une once de vérité est beaucoup plus efficace pour convaincre et toucher les gens.

Cette évolution répond en partie au durcissement des techniques employées par les moteurs de recherche et autres entreprises de réseaux sociaux pour enrayer la manipulation en masse de leur public. Ces derniers ont renforcé leur capacité à fermer les faux comptes et ont modifié leurs politiques pour être beaucoup plus agressifs contre les faux contenus (par exemple Facebook via son Projet de vérification des contenus par des tiers). C’est pourquoi les agents de la désinformation ont compris que le contenu authentique – reformulé de manière nouvelle et trompeuse – est moins susceptible d’être détecté par les systèmes d’IA. Dans certains cas, ce type de contenu est jugé incompatible avec la vérification des faits.

Par conséquent, une grande partie du contenu que nous voyons actuellement appartiendrait à la catégorie de la malinformation – des informations authentiques utilisées pour nuire.

Parmi ces trois archétypes du désordre informationnel, nous distinguons également fréquemment sept catégories afin d’aider les gens à comprendre la complexité de cet écosystème.

Elles ont été évoquées pour la première fois dans une publication de First Draft en février 2017 afin d’enrayer le recours systématique au terme de «fake news». Elles sont toujours utilisées comme un moyen utile d’illustrer différents exemples.

Comme le montre le diagramme précédent, nous considérons qu’il s’agit d’un spectre, la satire étant à l’une des extrémités. Il s’agit d’une position potentiellement controversée que nous aborderons au cours de ce livre, à travers le contenu «clickbait» (piège à clics), le contenu trompeur, le contenu authentique reformulé avec un faux contexte, le contenu imposteur (lorsque le logo d’une organisation ou le nom influent est accolé à de fausses informations), le contenu manipulé et enfin le contenu fabriqué. Dans les chapitres suivants, j’expliquerai chacune de ces catégories en détail et je proposerai des exemples qui soulignent à quel point le désordre informationnel a été préjudiciable dans le contexte des élections et des événements d’actualité à travers le monde.

Satire ou parodie

Lorsque nous avons publié ces catégories pour la première fois au début de 2017, certaines personnes ont réfuté l’idée que la satire pourrait y être incluse. Certes, la satire intelligente et la vraie parodie devraient être considérées comme des formes d’art. Le défi, à l’ère du désordre informationnel, est que la satire est utilisée de manière stratégique pour contourner les vérificateurs des faits et pour diffuser des rumeurs et des théories du complot, sachant que toute critique peut être écartée en déclarant qu’elle n’a jamais été conçue pour être prise au sérieux.

« De plus en plus, ce qui est qualifié de satire est haineux, polarisant et source de division. »

La raison pour laquelle la satire est un outil si puissant, c’est que les premières personnes à y être exposées la prennent souvent comme telle. Mais à mesure qu’elle est re-partagée, beaucoup perdent le lien avec le message d’origine et ne la voient pas comme de la satire.

Sur les réseaux sociaux, l’heuristique (les raccourcis mentaux que nous utilisons pour donner un sens au monde) fait défaut. Dans un journal, il est facile de comprendre dans quelle section du document nous nous trouvons et des indices visuels nous indiquent que nous sommes dans la section d’opinion ou la section de bande dessinée : ce n’est pas le cas en ligne.

Aux États-Unis, par exemple, vous connaissez peut-être The Onion, un site satirique très populaire. Mais combien d’autres en connaissez-vous ? Sur la page Wikipedia des sites satiriques, 57 sont répertoriés, et 22 d’entre eux sont aux États-Unis. Si vous voyez une publication re-partagée sur Facebook ou Instagram, ces indices contextuels sont

peu nombreux. Et souvent, lorsque ces articles se propagent, le lien avec la source d’origine est rapidement perdu car ils sont transformés en captures d’écran ou en mèmes.

En France, à l’approche des élections de 2017, nous avons vu cette technique visant à étiqueter du contenu comme « satirique » utilisée comme une tactique délibérée. Un exemple rédigépar Adrien Sénécat dans Le Monde montre l’approche pas à pas employée par ceux qui utilisent la satire de cette manière.

LA PHASE 1 : Le Gorafi, un site satirique, a « rapporté » que le candidat à la présidence française Emmanuel Macron se sentait sale après avoir touché les mains des pauvres.4 Cela a fonctionné comme une attaque contre Macron car il est régulièrement caractérisé comme étant peu accessible et élitiste.

LA PHASE 2 : Les pages Facebook hyper-militantes ont repris cette « affirmation » et ont créé de nouveaux articles, y compris des images de Macron visitant une usine et s’essuyant les mains pendant la visite.

LA PHASE 3 : Les vidéos sont devenues virales et un ouvrier travaillant dans une autre usine a mis Macron au défi de lui serrer « ses mains sales d’ouvrier ». Le cycle de l’actualité s’est poursuivi.

Une situation similaire s’est produite au Brésil, lors des élections présidentielles en octobre 2018. En fait, Ethel Rudnitzki a rédigé un article sur la forte hausse des comptes Twitter au Brésil en utilisant des jeux de mots liés à des organismes de presse et à des journalistes de haut niveau. Ils précisaient que les comptes étaient parodiques dans leur biographie mais, comme Rudnitzki l’a démontré, ces comptes ont été utilisés pour diffuser du contenu faux et trompeur.

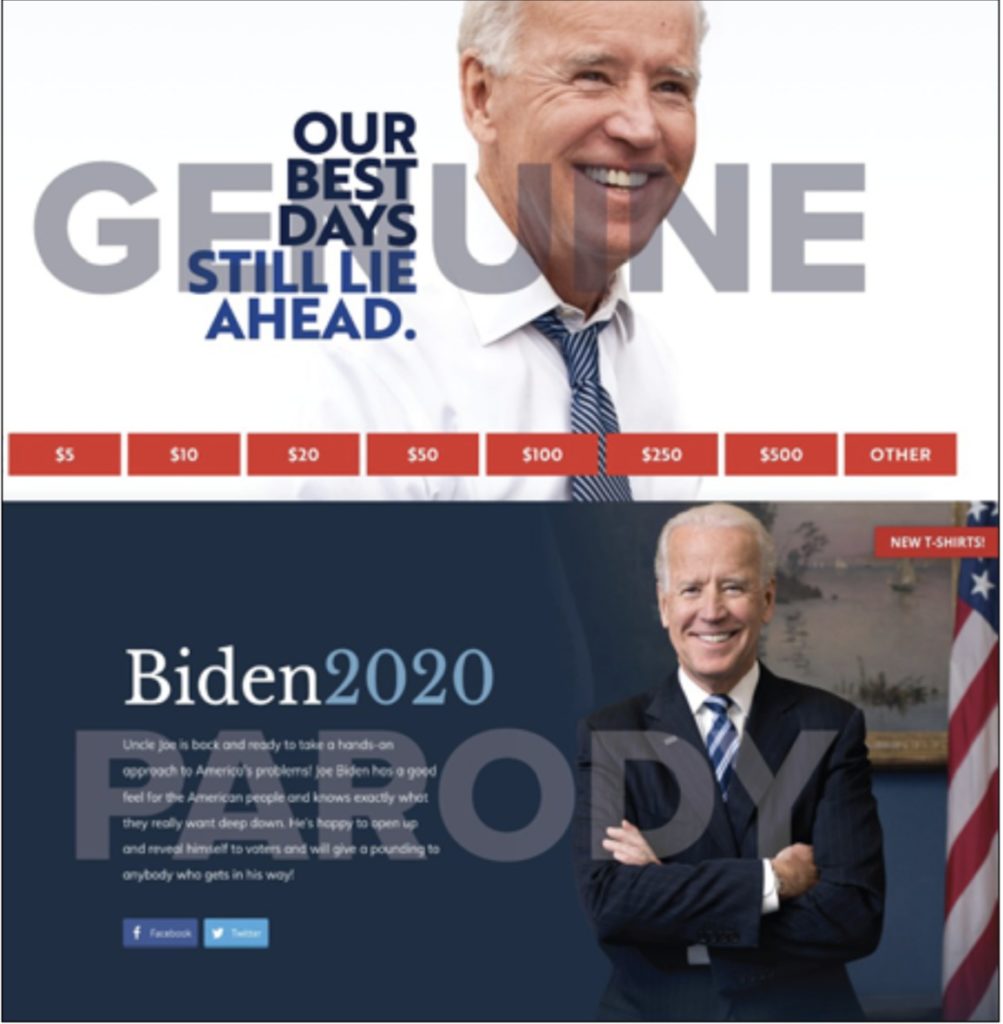

Aux États-Unis, en 2019, un membre du parti politique républicain a créé un site parodique conçu pour ressembler au site officiel de Joe Biden lorsque l’ancien vice-président s’est présenté comme candidat démocrate pour l’élection présidentielle de 2020. Avec l’URL « joebiden.info », le site parodique a été mieux indexé par Google que le site officiel de Biden joebiden.com quand il a lancé sa campagne en avril 2019. L’homme, qui avait déjà créé du contenu pour Donald Trump, a déclaré qu’il n’avait pas créé le site de la campagne Trump directement.

La première ligne du site parodique commençait ainsi : « Oncle Joe est de retour et il est prêt à adopter une approche pratique des problèmes de l’Amérique ! » Le site regorge d’images de Joe Biden embrassant des jeunes femmes et les prenant dans ses bras . Au bas de la page, la mention suivante est présente : « Ce site est une chronique politique et une parodie du site Web de la campagne présidentielle de Joe Biden. Ce n’est pas le véritable site Web de Joe Biden. Il est uniquement destiné à des fins de divertissement et de chroniques politiques. »

Certaines des complexités et des tensions autour de la satire et de la parodie ont été évoquées dans le cadre d’un différend public en ligne entre Babylon Bee (dont le slogan se lit comme suit : « Votre source de confiance en matière d’actualité satirique chrétienne ») et Snopes (un site de démystification établi). Snopes avait déjà vérifié des faits avancés par Babylon Bee à plusieurs reprises – la première fois concernant un article qui avait pour titre « CNN achète une machine à laver de taille industrielle pour faire laver les informations avant de les publier. »

Plus récemment, Snopes a vérifié une histoire de Babylon Bee qui avait pour titre « Un législateur de l’état de Géorgie affirme qu’un employé de Chick-Fil-A lui a dit de retourner dans son pays » – suggérant que dans le contexte d’un tweet

Les sites Web authentiques et parodiques de Joe Biden sont presque indiscernables à première vue. Extrait du 14 août 2019. Capture d’écran et superposition du texte par First Draft.

du président Trump intimant à quatre nouvelles membres du Congrès de « rentrer chez elles », le site satirique déformait ses blagues afin de tromper les lecteurs.

Un profil publié en novembre 2018 par le Washington Post du célèbre auteur de canulars Christopher Blair explique la complexité des problèmes liés à la satire.

Blair a commencé sa page Facebook satirique en 2016 comme une plaisanterie avec ses amis libéraux pour se moquer des idées extrémistes partagées par l’extrême droite. Il prenait soin de préciser qu’il s’agissait d’un site satirique avec pas moins de 14 avertissements, dont «rien sur cette page n’est réel».

Mais il a continué de gagner en popularité. Comme l’a écrit Blair sur sa propre page Facebook : «Peu importe à quel point nos contenus sont racistes, sectaires, offensants, manifestement faux, les gens reviennent continuellement.» De plus en plus, ce qui est qualifié de «satirique» est haineux, polarisant et source de division.

Comme nous venons de le voir dans ces exemples, bien qu’il puisse sembler délicat d’inclure la satire comme une catégorie à part entière, elle est devenue partie intégrante du débat sur la façon dont les informations peuvent être manipulées et reformulées pour produire un impact sur le public.

Fausse connexion

Dans le cadre du débat sur le désordre informationnel, le secteur de l’information doit reconnaitre son rôle dans la création de contenus qui ne répondent pas aux exigences de qualité attendues d’une profession aujourd’hui attaquée de tous les côtés. Cela peut conduire – et conduit – certains à qualifier les journalistes « d’ennemis du peuple ».

Je veux mettre en évidence les pratiques des rédactions qui peuvent contribuer au bruit, participer à la confusion et, en fin de compte, saper la confiance dans le « quatrième pouvoir ». L’une de ces pratiques est le contenu de type « pièges à clics », que j’appelle « fausse connexion ». Lorsque les organismes de presse utilisent un langage sensationnel pour générer des clics – avec un contenu qui n’est pas à la hauteur, le lecteur arrive sur le site – c’est une forme de pollution.

« S’il est possible d’utiliser ce type de techniques pour générer du trafic à court terme, il y aura sans aucun doute un impact à plus long terme sur la relation entre les gens et l’information. »

On pourrait faire valoir que le préjudice est minime lorsque le public connaît déjà la pratique, mais en tant que technique, elle devrait être considérée comme une forme de désordre informationnel. Certes, nous vivons à une époque de concurrence accrue quand il s’agit d’attirer l’attention et les rédactions ont du mal à survivre. Souvent, la force du titre d’un article peut faire la différence entre une poignée de lecteurs abonnés et un public plus large.

En 2014, Facebook a modifié son algorithme de flux d’actualités, en particulier en attribuant un mauvais classement aux sites qui utilisaient des titres «pièges à clics». Lors d’une autre mise à jour en 2019, Facebook a détaillé comment il utilisait les résultats de sondages pour hiérarchiser les publications qui comprenaient des liens que les utilisateurs avaient jugés plus «dignes d’intérêt» . Une étude menée par le Engaging News Project en 2016 a démontré que «le type de titre et la source du titre pouvaient affecter la manière dont une personne réagissait plus ou moins positivement à un projet d’actualité et son intention d’utiliser ce produit à l’avenir».

Le besoin de générer du trafic et des clics rend peu probable la disparition des techniques de piège à clics, mais l’utilisation d’un langage polarisant et émotif pour générer du trafic est liée aux problèmes plus larges exposés dans ces guides. S’il est possible d’utiliser ces types de techniques pour générer du trafic à court terme, il y aura sans aucun doute un impact à plus long terme sur la relation entre les gens et l’information.

Contenu trompeur

Les informations trompeuses sont loin d’être nouvelles et se manifestent de multiples façons. Reformuler les histoires dans les titres, utiliser des fragments de citations pour étayer un argument plus général, citer des statistiques d’une manière biaisée ou décider de ne pas couvrir un sujet car il va à l’encontre d’un argument sont toutes des techniques reconnues – et sournoises. Pour faire valoir une idée, les gens sont enclins à utiliser du contenu qui valide leur argumentation globale.

Il y a quelques années, un ingénieur d’une grande entreprise technologique m’a demandé de définir le terme «trompeur». J’ai été momentanément déconcertée parce qu’à chaque fois que j’essayais de définir le terme, je n’arrivais pas à le formuler et j’ai fini par répondre : «On le sait, c’est tout. On sait quand c’est «trompeur».»

Il est difficile de définir exactement le terme « trompeur », car cela dépend du contexte et des nuances, ainsi que de la quantité d’informations qui est omise dans une citation. Dans quelle mesure les statistiques ont-elles été manipulées ? La façon dont une photo a été recadrée a-t-elle considérablement changé le sens de l’image ?

Cette complexité explique pourquoi l’intelligence artificielle n’arrive toujours pas à signaler ce type de contenu. C’est pourquoi l’ingénieur voulait une définition claire. Les ordinateurs comprennent le vrai et le faux, mais le trompeur est une zone grise. L’ordinateur doit comprendre le contenu original (la citation, la statistique, l’image), reconnaître le fragment, puis déterminer si le fragment change le sens de l’original de manière significative.

Il y a une différence considérable entre le contenu hyper-militant sensationnel et les légendes légèrement trompeuses qui reformulent un problème et affectent la façon dont quelqu’un pourrait interpréter une image. Mais la confiance dans les médias a chuté. Le contenu trompeur qui aurait pu être considéré comme inoffensif auparavant devrait désormais être vu différemment.

Une étude de septembre 2018 réalisée par la Knight Foundation et Gallup a révélé que la plupart des Américains perdaient confiance dans les médias, et que leurs raisons étaient principalement liées aux problèmes d’exactitude ou de parti pris.

Le contenu trompeur peut prendre plusieurs formes, mais cet exemple tiré du New York Times montre comment les visuels peuvent également induire en erreur. Lorsque vous regardez le marteau qui représente Obama (15 jugements d’appel confirmés) et que vous le comparez à celui de Trump (24), l’échelle du graphique n’est pas alignée.

Une illustration comparant les confirmations présidentielles de jugements d’appel est trompeuse car la taille des marteaux n’est pas à l’échelle. Le marteau du président Trump devrait être deux fois plus gros que celui du président Obama. Source : How the Trump Administration Is Remaking the Courts, New York Times, 22 août 2018. Archivé le 6 septembre 2019. Site Capture d’écran de l’auteure.

Faux contexte

Cette catégorie regroupe les contenus qui sont authentiques, mais qui ont été reformulés de manière dangereuse. L’un des exemples les plus poignants de cette technique a été publié peu de temps après une attaque terroriste islamiste sur le pont de Westminster à Londres en 2017. Une voiture s’est engagée sur le trottoir et a roulé le long du pont, causant 50 blessés et quatre morts, avant de s’écraser aux portes du Parlement.

Un tweet (ci-contre) a été largement diffusé à la suite du drame. C’est une image authentique. Pas une fausse. Elle a été largement partagée, en utilisant une formulation islamophobe et un certain nombre de hashtags dont #banislam.

La femme sur la photo a ensuite été interviewée et a expliqué qu’elle était traumatisée, au téléphone avec un être cher et, par respect, évitant la victime du regard. Nous savons maintenant que ce compte, Texas LoneStar, faisait partie d’une campagne de désinformation russe et a depuis été fermé.

Un compte lié à une campagne de désinformation russe suggère que la femme musulmane représentée était indifférente à la victime de l’attaque, présente à sa droite. En réalité, elle avait évité de regarder la victime par respect. Le compte a été supprimé mais est signalé dans le Guardian. Archivé le 6 septembre 2019. et The Telegraph Archivé le 10 décembre 2019.

Un autre exemple qui a suscité une vive indignation à l’époque était une image d’un enfant à l’intérieur d’une cage qui a circulé au cours de l’été 2018.

Cette photo représentant un enfant dans une cage a été mise en scène dans le cadre d’une manifestation contre les politiques d’immigration. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

Elle a suscité plus de 20 000 retweets Un article similaire sur Facebook a été partagé plus de 10 000 fois. La photo était en fait une mise en scène dans le cadre d’une manifestation contre les politiques d’immigration qui avait eu lieu deux jours auparavant à l’hôtel de ville de Dallas – un autre exemple d’une image authentique où le contexte a été reformulé et déformé. Dans cet exemple, cependant, l’auteur ne s’est pas rendu compte qu’il s’agissait d’une manifestation lorsqu’il a partagé l’image. C’était un cas de mésinformation, pas de désinformation.

Dans la même veine, pendant la période qui a précédé les élections de mi-mandat aux États-Unis, il y a eu une forte couverture d’une multitude de migrants se rendant aux États-Unis depuis l’Amérique centrale. Les images authentiques ont été partagées, mais avec une formulation trompeuse. La première, publiée sur Facebook, représentait en fait une image de réfugiés syriens en Turquie en 2015.

Cette photo avait été publiée dans le contexte de la « nuée » de migrants aux États-Unis, mais il s’agit en fait d’une photo de réfugiés syriens en Turquie qui date de 2015. L’image originale avait été partagée par le photographe sur Twitter. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

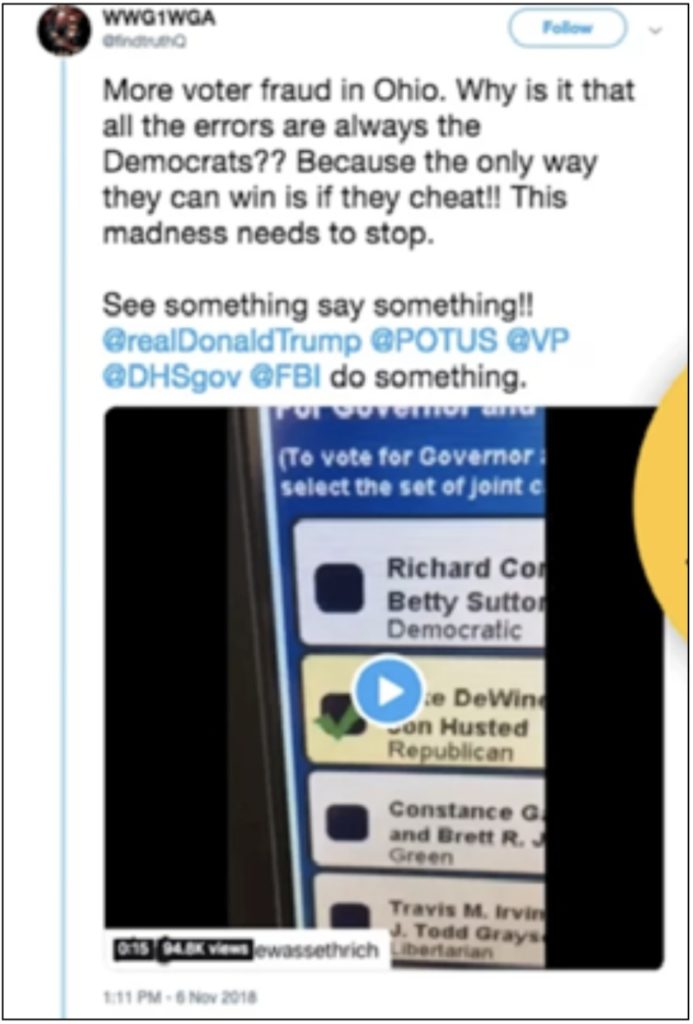

Un autre exemple de faux contexte est un tweet qui a circulé le jour du scrutin lors des élections de mi-mandat de 2018. Il s’agissait d’une vidéo authentique d’une machine électorale défectueuse qui surlignait le mauvais nom lorsqu’on appuyait dessus. La machine a été mise hors service et la personne a eu la possibilité de voter sur une machine qui fonctionnait correctement. Mais ce tweet, diffusé par utilisateur dont le nom faisait référence à la théorie du complot QAnon, a utilisé la vidéo pour suggérer qu’il s’agissait d’un exemple plus sérieux de fraude électorale ciblée.

Un utilisateur a diffusé cette vidéo d’une machine électorale défectueuse comme preuve d’une fraude électorale généralisée. En réalité, la machine a été mise hors service et l’électeur qui a pris la photo a été autorisé à voter de nouveau. Le tweet a été supprimé mais a été signalé par BuzzFeed. Archivé le 6 septembre 2019. Capture d’écran par Jane Lytvynenko pour Buzzfeed.

Contenu imposteur

Comme évoqué précédemment, notre cerveau est toujours à la recherche d’une analyse heuristique pour comprendre des choses, notamment pour évaluer la crédibilité des informations. L’heuristique est un raccourci mental qui nous aide à comprendre le monde. Le fait de voir une marque qui nous est familière est en soi une heuristique très puissante. C’est pour cette raison que nous observons une augmentation du contenu imposteur – contenu faux ou trompeur qui utilise des logos bien connus ou des informations provenant de personnalités ou de journalistes établis.

C’est lorsque je travaillais pour l’Agence des Nations Unies pour les réfugiés en 2014 que j’ai découvert pour la première fois un contenu imposteur conçu pour nuire. Nous nous battions constamment contre des publications Facebook dans lesquelles des passeurs créaient des pages avec le logo du HCR et publiaient des images de yachts somptueux en expliquant aux réfugiés qu’ils devaient «appeler ce numéro» pour obtenir une place sur l’un de ces bateaux qui les ferait traverser la Méditerranée en toute sécurité.

Depuis lors, nous voyons toujours des exemples d’agents de désinformation qui utilisent les logos d’organismes de presse établis pour colporter du contenu faux et trompeur. Voici deux exemples dans lesquels la BBC est utilisée de cette manière. L’un a circulé avant les élections générales de 2017 au Royaume-Uni et a été publié sur les réseaux sociaux. L’image indique que l’élection se déroule sur deux jours, et en fonction de votre affiliation à un parti, vous devez voter le bon jour.

Un site d’informations imposteur a utilisé le logo de la BBC pour colporter des informations trompeuses sur les élections au Royaume-Uni. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

L’autre a circulé sur WhatsApp avant les élections générales de 2017 au Kenya. La BBC a vérifié les faits, indiquant que la vidéo n’était pas la leur, malgré l’utilisation intelligente du logo BBC.

Une vidéo qui a circulé sur WhatsApp a utilisé le logo de BBC TV sur leur propre contenu au sujet des élections au Kenya en 2017. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

Un exemple plus sinistre a émergé lors de l’élection présidentielle américaine de 2016 où NowThis a été contraint de réfuter une vidéo fabriquée qui circulait avec son logo.

Une vidéo de type imposteur sur la famille Clinton présentée comme du contenu produit par l’entreprise de médias NowThis en utilisant leur image de marque. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

En 2017, une version sophistiquée de type imposteur du journal Le Soir en Belgique a affirmé que Macron était financé par l’Arabie saoudite. Elle était si sophistiquée que tous les liens hypertextes de cette version vous amenaient sur le vrai site du Soir.

Un site imposteur se faisant passer pour le journal belge Le Soir était particulièrement sophistiqué car tous ses liens dirigeaient les utilisateurs vers le vrai site du Soir . Le site imposteur a été supprimé mais l’article original du site est disponible sur le site CrossCheck France. Archivé le 6 septembre 2019.

La fusillade de Parkland, en Floride, en février 2018 a été la toile de fond de deux nouvelles techniques très inquiétantes dans cette catégorie de contenu imposteur. La première impliquait une personne qui avait modifié un article du Miami Herald sur Photoshop pour ajouter un autre paragraphe (suggérant qu’une autre école avait reçu la menace d’une tuerie similaire), avant d’en faire une capture d’écran et de la diffuser ensuite sur Snapchat.

Quelqu’un a ajouté un nouveau paragraphe dans un article du Miami Herald avec Photoshop pour faire croire, à tort, que d’autres écoles avaient reçu des menaces de fusillade. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

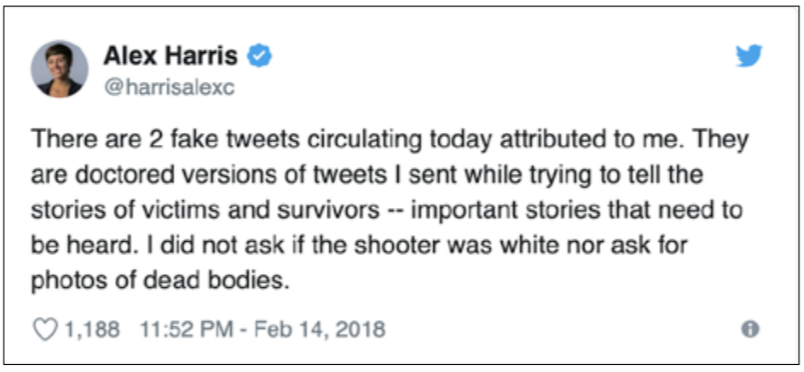

L’autre exemple concernait également le Miami Herald, mais cette fois-ci, c’est une journaliste, Alex Harris, qui avait été prise pour cible. À l’aide d’un site générateur de faux tweets qui permettait de saisir le pseudonyme d’un utilisateur et d’y ajouter la véritable photo et biographie du profil, quelqu’un a créé deux tweets offensants. Ils ont été diffusés sous forme de captures d’écran. Quiconque est allé sur la page Twitter de Harris aurait vu qu’elle n’avait pas tweeté de tels messages, mais à une époque où les gens sauvegardent les tweets controversés avant qu’ils ne soient supprimés, elle n’avait aucun moyen immédiat de prouver une fois pour toute qu’elle n’avait pas posté les messages. Cet événement a été un signal d’alarme, rappelant aux journalistes qu’ils peuvent se retrouver pris pour cible de cette façon.

Quand une personne a fabriqué deux tweets offensants sur photoshop pour donner l’impression qu’ils provenaient de la journaliste Alex Harris, elle a alerté les utilisateurs de Twitter sur son propre compte, mais elle n’avait aucun moyen de prouver qu’ils n’étaient pas vrais. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

Un autre exemple célèbre de contenu imposteur est apparu pendant la période précédant l’élection présidentielle américaine de 2016. En utilisant le logo officiel de Hillary Clinton, une personne a créé l’image suivante qui a ensuite été utilisée pour cibler précisément certaines communautés de couleur afin d’essayer de censurer le vote.

An ad that claims it was paid by Hillary Clinton’s presidential campaign makes it look like Hillary supporters have unfair voting advantages, but the ad is entirely fabricated. The account has since been deleted but original reporting and links are available at The Washington Post. Archived on September 6 2019. Screenshot by author.

Pour mémoire, la quantité d’informations à laquelle les gens sont exposés quotidiennement, rien que sur leur téléphone (e-mails, notifications sur les réseaux sociaux et alertes), rend l’heuristique encore plus percutante. Par conséquent, un logo, une formule exacte des clauses de non-responsabilité ou la signature d’un journaliste connu a un impact disproportionné.

En plus du texte, des vidéos et des images, nous devons de plus en plus être conscients de la puissance de l’audio en matière de tromperie. À l’approche de l’élection présidentielle brésilienne d’octobre 2018, Jair Bolsonaro a été poignardé lors d’un événement de campagne. Il a passé les 17 jours suivants à l’hôpital. Pendant ce temps, un message audio qui prétendait être de Bolsonaro a circulé dans lequel il avait insulté les infirmières et avait déclaré que « le cinéma était terminé ». Cela a conduit à l’émergence de théories du complot affirmant que le coup de couteau avait été délibérément mis en scène pour accroître la sympathie du public et donc le soutien au candidat. Des spécialistes de l’audio ont pu analyser l’enregistrement et confirmer que la voix n’était pas celle de Bolsonaro – mais qu’il s’agissait d’une imitation qui avait l’air authentique.

Enfin, une autre technique qui a été étudiée par Snopes est la création de sites qui ressemblent à des sites professionnels d’actualités locales, comme The Ohio Star ou le Minnesota Sun. Des consultants républicains ont mis en place un réseau de ces sites, conçu pour ressembler à des sites d’actualités locales réputés.

Cinq de ces sites font partie du réseau Star News Digital Media. Ils sont en partie financés par les candidats républicains dont ces sites d’informations parlent.

Un site qui se présente comme un journal local de l’Ohio était en fait créé par des consultants républicains.Récupéré le 16 octobre 2019.24 Capture d’écran par l’auteure.

d’actualités locales réputés font en fait partie d’un réseau de sites mis en place par des consultants républicains. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

Contenu manipulé

On parle de média manipulé lorsqu’un aspect du contenu authentique est altéré. Cela concerne le plus souvent des photos ou des vidéos. Voici un exemple de la période précédant l’élection présidentielle américaine de 2016, lorsque deux images authentiques ont été assemblées. La scène a lieu en Arizona, et la photo des personnes faisant la queue pour voter provient des primaires de 2016. L’image de l’agent de l’ICE (agence de police douanière et de contrôle des frontières du département de la Sécurité intérieure des États-Unis) procédant à l’arrestation était une image provenant d’une banque d’images qui, à l’époque, était la première photo qui apparaissait sur Google Images lorsque l’on cherchait l’arrestation de l’ICE. La deuxième image a été taillée et superposée à la première et largement diffusée en amont des élections.

Ces deux images ont été superposées pour faire croire que des agents de l’ICE étaient présents sur un lieu de vote. Archivé le 16 octobre 2019.

Un autre exemple de contenu manipulé très médiatisé visait Emma Gonzalez, une lycéenne, et trois de ses amis qui avaient survécu à la fusillade de l’école à Parkland, en Floride. Ils avaient été photographiés pour apparaître sur la couverture de Teen Vogue et le magazine avait créé une vidéo, promue sur Twitter, de Gonzalez déchirant une cible de tir en deux.

Une image authentique de la survivante de Parkland Emma Gonzalez avant qu’elle ne déchire une cible de tir sur la couverture de Teen Vogue. Archivé le 6 septembre 2019.

Cette vidéo a été modifiée pour donner l’impression que Gonzalez déchire la constitution américaine en deux. Elle a été partagée par des milliers de personnes, y compris des célébrités comme l’acteur Adam Baldwin.

Une vidéo truquée d’Emma Gonzalez, survivante de Parkland, déchirant la Constitution américaine. Ce tweet a maintenant été supprimé mais a été signalé par BuzzFeed. Archivé le 6 septembre 2019.

Un autre exemple tristement célèbre concerne une vidéo de la présidente de la Chambre des représentants des États-Unis, Nancy Pelosi, prononçant un discours en mai 2019. La vidéo avait été légèrement ralentie et cette simple forme de manipulation a réussi à faire apparaître Pelosi comme ivre et bredouillante.

Une vidéo de la présidente de la Chambre des représentants américaine Nancy Pelosi a été ralentie pour la faire paraître ivre. La vidéo a été créée par le Washington Post. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

La même technique a été utilisée à nouveau en Argentine et a visé la ministre de la Sécurité Patricia Bullrich à l’approche des élections d’octobre 2019.

Une vidéo de la ministre argentine de la Sécurité, Patricia Bullrich, a également été ralentie pour la faire paraître ivre. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

Contenu fabriqué

Le contenu fabriqué est 100 % faux. Par exemple, une fausse affirmation selon laquelle le pape François avait soutenu Donald Trump a circulé avant les élections présidentielles américaines de 2016, suscitant beaucoup d’attention. Le titre figurait sur un site appelé WTOE5 qui a colporté un certain nombre de fausses rumeurs avant les élections.

Cet article prétend que le pape François avait approuvé la candidature de Donald Trump à la présidence, mais ce n’était pas vrai. Le site n’est plus en ligne mais a été démystifié par Snopes. Archivé le 6 septembre 2019. Capture d’écran de l’auteure.

La vidéo d’un aigle qui semble voler un bébé dans un parc en 2012 est un bon exemple. La vidéo a été visionnée plus de 40 millions de fois avant que l’on apprenne qu’elle avait été créée dans le cadre d’un devoir de classe pour créer du contenu susceptible de tromper les téléspectateurs. Les étudiants avaient généré un aigle sur ordinateur et il était si crédible que seule une analyse image par image a montré que son aile se détachait de son corps pendant une fraction de seconde et que son ombre apparaissait ensuite d’on ne sait où en arrière-plan de la séquence.

Un autre exemple de contenu 100 % fabriqué est une vidéo qui est apparue en 2014. Elle semblait montrer une fusillade en Syrie où un garçon sauvait une jeune fille. Des images du film ont fait la couverture du New York Post. Il s’est avéré que la vidéo avait été créée par des cinéastes, tournée à Malte, sur le même plateau de tournage que celui du film Gladiator. Ils ont voulu attirer l’attention sur les horreurs qui avaient eu lieu en Syrie, mais leurs actions ont été condamnées par des militants des droits humains qui ont fait valoir que ce type de fabrication minait leurs efforts pour documenter les véritables atrocités.

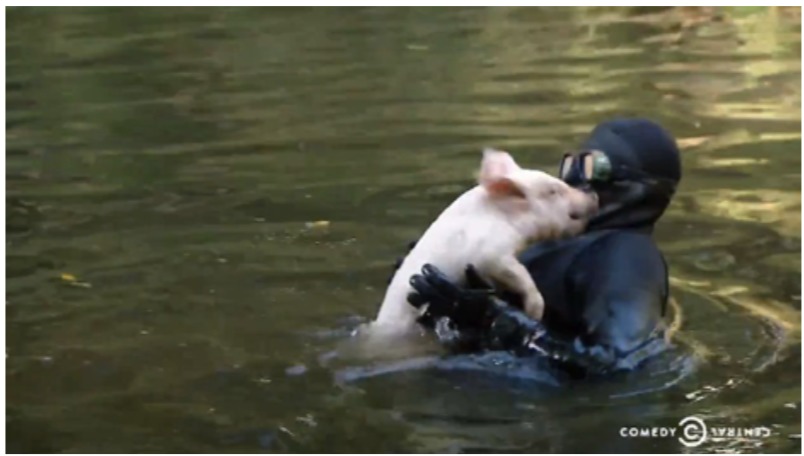

Un autre exemple moins tragique est considéré comme l’une des fabrications virales les plus réussies. Créée par l’émission Comedy Central « Nathan for You », elle représente un cochon sauvant une chèvre en train de se noyer dans un étang. La vidéo avait été largement partagée et présentée dans la dernière rubrique de l’émission. Il a fallu plus de six mois avant que Comedy Central ne diffuse une vidéo expliquant les efforts qu’ils avaient déployés pour créer le clip. Ils avaient construit une « piste de bowling » en plexiglas sous l’eau et des plongeurs guidaient le cochon vers la chèvre !

Comedy Central a créé une installation sous-marine élaborée pour donner l’impression qu’un cochon avait sauvé une chèvre en train de se noyer. Les gens ont cru que la vidéo était réelle et l’ont massivement partagée. Sur la chaîne YouTube Comedy Central. Archivé le 6 septembre 2019.Capture d’écran de l’auteure.

Enfin, tournons nous vers l’avenir du contenu fabriqué. La prochaine vague sera le fruit de l’intelligence artificielle, autrement connue sous le nom de « deepfakes ». Nous avons vu ce qu’il est possible de faire avec le deepfake de Jordan Peele dans lequel il a créé une version du président Obama.

Et plus récemment, nous avons vu des documentaristes créer un clip de Mark Zuckerberg en guise de test pour voir si Instagram le retirerait. Ironie du sort, alors qu’Instagram avait déclaré que la vidéo n’avait pas enfreint leurs politiques, CBS avait fini par signaler le contenu, arguant qu’il s’agissait de contenu imposteur car leur logo était utilisé (voir chapitre 4).

Un clip fabriqué de Mark Zuckerberg n’a pas été retiré par Facebook, mais CBS a signalé le contenu qui utilisait leur logo. Archivé le 6 septembre 2019.

Conclusion

Le désordre informationnel est un sujet complexe. Certaines formes pourraient être décrites comme une pollution de l’information de bas niveau -des titres « pièges à clics », des légendes bâclées ou une satire qui plaisante – mais certaines sont sophistiquées et profondément trompeuses

Afin de comprendre, d’expliquer et de relever ces défis, le langage que nous utilisons est important. La terminologie et les définitions sont importantes.

Comme ce guide l’a démontré, il existe de nombreux exemples des différentes façons dont le contenu peut être utilisé pour piéger, tromper et manipuler. Plutôt que de les voir comme un tout, décomposer ces techniques peut aider votre rédaction et votre public à mieux comprendre les défis auxquels nous sommes désormais confrontés.

Cliquez ici pour télécharger une version PDF de ce guide.